GTC 2024 – انویدیا (Nvidia) در رویداد GTC 2024، بمب جدیدی را منفجر کرد: GPU Blackwell B200، جانشین قدرتمند Hopper H100. این GPU جدید با تمرکز بر هوش مصنوعی (AI) و محاسبات دادهمحور، بیش از 4 برابر عملکرد Hopper را ارائه میدهد و آینده سوپرکامپیوترهای AI را تغییر میدهد. اگر به دنبال جزئیات Nvidia Blackwell هستید، این مقاله همه چیز را پوشش میدهد – از مشخصات فنی تا تأثیر آن بر صنعت AI.

چرا Blackwell B200 یک جهش عظیم است؟

انویدیا با Blackwell B200، مرزهای محاسبات AI را جابهجا کرده است. این GPU با 208 میلیارد ترانزیستور (بیش از دو برابر H100 با 80 میلیارد ترانزیستور)، 20 پتافلاپس عملکرد AI در فرمت FP4 ارائه میدهد – در حالی که H100 تنها 4 پتافلاپس داشت. این یعنی 4X افزایش سرعت در آموزش و استنتاج مدلهای بزرگ AI.

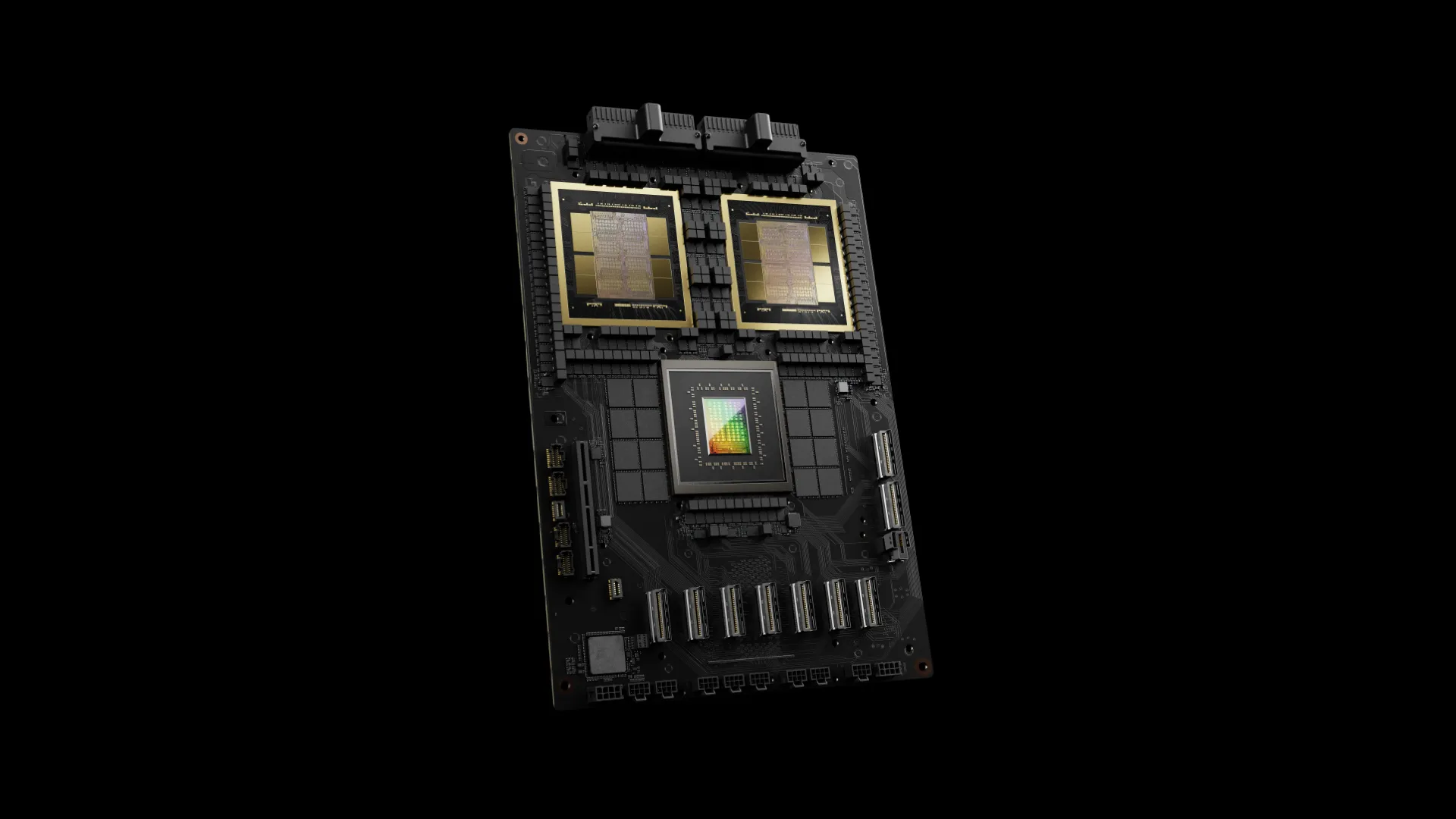

علاوه بر این، B200 از 192 گیگابایت حافظه HBM3e با پهنای باند 8 ترابایت بر ثانیه بهره میبرد. اما نکته جالب: این GPU تکچیپ نیست! دو die به هم متصل با رابط NV-HBI 10 ترابایت بر ثانیه، یک GPU واحد CUDA میسازند. این طراحی به دلیل محدودیتهای فرآیند TSMC 4NP (نسخه بهبودیافته 4N Hopper) انتخاب شده و اجازه میدهد تا بدون افزایش چشمگیر اندازه die، قدرت بیشتری بسازیم.

مشخصات کلیدی GPU Blackwell B200 و مقایسه با Hopper H100

برای درک بهتر، جدول زیر عملکرد B200 را با H100 مقایسه میکند (با تمرکز بر فرمتهای رایج AI). توجه: اعداد با sparsity (فشردهسازی) محاسبه شدهاند و بدون آن نصف میشوند.

| فرمت محاسباتی | Blackwell B200 (پتافلاپس) | Hopper H100 (پتافلاپس) | افزایش عملکرد |

|---|---|---|---|

| FP4 Tensor | 20 (Dense) / 40 (Sparse) | – | 5X+ (جدید) |

| FP8/FP6 Tensor | 10 / 20 | 4 / 8 | 2.5X |

| FP16/BF16 Tensor | 5 / 10 | 2 / 4 | 2.5X |

| TF32 Tensor | 2.5 / 5 | 1 / 2 | 2.5X |

| FP64 Tensor (Dense) | 0.045 (45 TFLOPS) | 0.06 (60 TFLOPS) | 0.75X (کاهش برای تمرکز روی AI) |

| حافظه | 192GB HBM3e | 80GB HBM3 (H200: 141GB) | 2.4X |

| پهنای باند | 8 TB/s | 3.35 TB/s | 2.4X |

| مصرف برق (TDP) | 1000W | 700W | 1.4X |

نکته مهم: B200 از فرمت جدید FP4 (دو برابر سریعتر از FP8) و FP6 (برای دقت متوسط) پشتیبانی میکند. موتور Transformer Engine نسل دوم انویدیا، مدلها را به طور خودکار بهینه میکند تا حداکثر سرعت را بگیرید.

سوپرخپ GB200: ترکیب Grace CPU و دو B200 GPU

انویدیا فقط GPU نساخت؛ Grace Blackwell GB200 سوپرخپ را معرفی کرد که یک Grace CPU را با دو B200 GPU جفت میکند. این ترکیب:

- 384GB حافظه با 16 TB/s پهنای باند.

- تا 2700W TDP (1200W برای هر GPU + 300W CPU).

- 40 پتافلاپس FP4 (دو برابر B200 تک).

این سوپرخپ برای مدلهای “Mixture of Experts” (MoE) ایدهآل است و عملکرد FP64 را به 90 TFLOPS میرساند.

NVLink 5 و NVSwitch: حل bottleneck ارتباطات

در workloads AI بزرگ، ارتباطات بین GPUها تا 60% زمان را میگیرد. انویدیا با NVLink نسل 5 و NVSwitch 7.2T این مشکل را حل کرد:

- هر B200: 18 لینک NVLink با 100 GB/s دوطرفه (18X بیشتر از H100).

- NVSwitch: 1.8 TB/s bandwidth، پشتیبانی از 576 GPU، و 3.6 TFLOPS Sharp v4 برای پردازش in-network.

- افزایش 18X سرعت interconnect نسبت به Hopper.

سیستمهای بزرگ: NVL72 و SuperPOD

- GB200 NVL72: رک کامل با 72 B200 GPU و 36 Grace CPU. 1440 پتافلاپس FP4، 130 TB/s bandwidth، و پشتیبانی از مدلهای 27 تریلیون پارامتر. (مقایسه: 4X آموزش سریعتر و 30X استنتاج سریعتر از H100).

- SuperPOD: تا 576 GPU (8 NVL72)، 11.5 اگزافلاپس FP4، و مقیاسپذیری به هزاران GPU. مثالی از 56 SuperPOD: 645 اگزافلاپس و 13PB حافظه!

انویدیا با AWS، Google Cloud و Oracle همکاری میکند تا این سیستمها را در ابر عرضه کند – مانند Project Ceiba با 20,000+ B200 GPU.

Blackwell B100: نسخه سازگار با H100

برای مهاجرت آسان، B100 با TDP 700W (مانند H100) و 14 پتافلاپس FP4 عرضه میشود. HGX B100 (8 GPU) مستقیماً جایگزین HGX H100 است.

آینده Blackwell: تولید و رقابت

تولید B200 از اواخر 2024 شروع میشود. قیمت؟ H100 حدود 40,000 دلار است، پس B200 ممکن است به 100,000 دلار برسد – اما ارزشش را دارد! انویدیا با تمرکز 10 ساله روی AI، رقبا را پشت سر گذاشته (رشد 126% درآمد دادهسنتر).

سؤالهای متداول (FAQ):

- Blackwell برای مصرفکننده میآید؟ احتمالاً در 2025، اما متفاوت از نسخه دادهسنتر.

- بهبود انرژی؟ تا 25X کارایی بهتر نسبت به H100 در مدلهای بزرگ.

- رقابت با AMD/Intel؟ انویدیا فعلاً پیشتاز است، اما رقبا در حال تعقیباند.

دیدگاه ها بسته هستند